Alibaba le apunta a Google y OpenAI: Conoce a Qwen2.5-Omni, la IA de código abierto que ve, oye y habla

La carrera por la inteligencia artificial (IA) tiene un nuevo competidor importante. Mientras que Gemini de Google y OpenAI nos han impresionado con sus capacidades para entender imágenes, videos, audio y texto, el equipo de Qwen de Alibaba ha lanzado una posible bomba: Qwen2.5-Omni. No es solo otro modelo de lenguaje grande (LLM); se presenta como una IA multimodal "omnidireccional" diseñada para percibir el mundo como nosotros. Procesa texto, imágenes, audio y video, respondiendo no solo con texto, sino también con voz sintetizada en tiempo real.

¿Lo más importante? Alibaba ha liberado el código fuente de la versión de 7 mil millones de parámetros, Qwen2.5-Omni-7B, bajo una licencia Apache 2.0. Esto podría poner herramientas de IA multimodal sofisticadas directamente en manos de desarrolladores y empresas de todo el mundo, gratis para uso comercial. Es una jugada audaz que desafía a los grandes de la competencia.

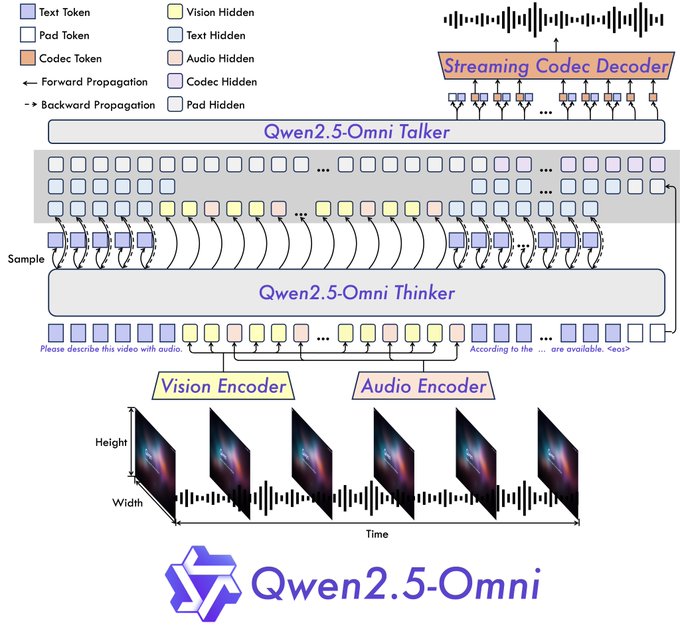

¿Qué hay dentro? La arquitectura "Pensador-Hablador"

Alibaba no solo le añadió "sentidos" a un LLM que ya existía. Presentaron una nueva arquitectura llamada "Pensador-Hablador".

- El Pensador: Este componente actúa como el cerebro. Recibe toda la información (texto, imágenes, sonidos) y la procesa para entender el contexto y crear ideas importantes, junto con la respuesta principal en texto. Utiliza codificadores especiales para audio y visión para sacar la información importante.

- El Hablador: Como la boca y las cuerdas vocales, el Hablador recibe la información y el texto del Pensador en tiempo real. Luego, lo transforma en partes de audio separadas, creando un flujo de voz natural junto con el texto escrito.

Este diseño completo es clave para permitir experiencias interactivas en tiempo real. La arquitectura admite información dividida en partes y respuestas inmediatas, buscando conversaciones más parecidas a una videollamada que a un chat por turnos.

Además, Qwen2.5-Omni usa una nueva técnica de ubicación llamada TMRoPE (RoPE Multimodal Alineado en el Tiempo). Esto resuelve un problema difícil: sincronizar bien los cuadros de video con los segmentos de audio en una misma línea de tiempo. Hacer esto bien es muy importante para entender las acciones y el habla dentro del video correctamente.

Afirmaciones de rendimiento vs. Pruebas reales: ¿Buenos sentidos, poca inteligencia?

Alibaba dice que Qwen2.5-Omni logra los mejores resultados en OmniBench, una prueba creada para tareas multimodales integradas. También dicen que supera a modelos del mismo tamaño, incluyendo a competidores con código cerrado como Gemini 1.5 Pro de Google en ciertas tareas, e incluso a modelos especializados en una sola cosa de su propia línea (como Qwen2.5-VL-7B para visión y Qwen2-Audio).

Las demostraciones oficiales y las primeras pruebas de usuarios muestran una imagen interesante, pero con altibajos:

- Lo bueno – Habilidad Multimodal:

- Visión: Identificó correctamente "comportamiento sospechoso" en una imagen de seguridad simulada, dando la clasificación y la explicación correctas.

- Video: Al darle un video de baile, dio una descripción detallada de la ropa del bailarín, sus movimientos y el lugar.

- Audio: Resumió correctamente los pasos para hacer Cerdo Estofado Rojo a partir de una receta de audio.

- Interacción: La salida de texto y voz natural al mismo tiempo (manejando bien inglés y chino mezclados) es rápida y fluida, creando una sensación de conversación real. Las demostraciones muestran videollamadas donde la IA describe el entorno, actúa como asistente de recetas guiada por voz, critica borradores de canciones, analiza bocetos e incluso explica problemas de matemáticas paso a paso a partir de una foto.

- Lo malo – Fallos de razonamiento y problemas prácticos:

- Errores de lógica básica: A pesar de su procesamiento sensorial avanzado, el modelo de demostración de 7B se equivocó en tareas de razonamiento sencillas. Al preguntar "¿Cuál es más grande, 6.9 o 6.11?", dijo incorrectamente que 6.9 es más pequeño. Al preguntar cuántas 'r' hay en "strawberry", respondió dos (hay tres). Esto sugiere una posible diferencia entre la capacidad de ver y oír y el razonamiento, al menos en esta versión accesible.

- Uso de recursos: Algunos usuarios que intentaron ejecutar el modelo en su computadora dijeron que necesitaba mucha memoria de video (VRAM), con un caso que mostró un error de falta de memoria en una configuración de 100 GB de VRAM para un video de 21 segundos. Otros notaron errores con imágenes más grandes y tiempos de respuesta lentos (minutos por respuesta), lo que indica que usarlo de manera eficiente podría necesitar optimización o computadoras especiales.

- Idioma y personalización: Si bien la salida de voz en inglés y chino es buena, los usuarios notaron limitaciones con otros idiomas como español y francés. La salida de voz actualmente copia el texto; más opciones de personalización serían útiles para usos específicos. También se dijo que la facilidad de uso para personas que no son expertas necesita mejoras.

La jugada de código abierto: ¿Hacer que la IA multimodal sea para todos?

La decisión de Alibaba de liberar el código fuente de Qwen2.5-Omni-7B bajo la licencia Apache 2.0, que permite su uso comercial, es lo más importante de esta versión.

- Bajar las barreras: Permite que nuevas empresas, investigadores e incluso empresas grandes prueben y usen IA multimodal avanzada sin los altos costos de las API o las licencias de los modelos cerrados. Esto podría impulsar la innovación en áreas como:

- Herramientas de accesibilidad: IA que puede describir el mundo para personas con problemas de visión.

- Educación: Tutores interactivos que pueden ver el trabajo de un estudiante y escuchar sus preguntas.

- Asistencia creativa: Herramientas que critican arte visual, música o escritura basándose en diferentes tipos de información.

- Dispositivos inteligentes: Permitir una interacción más natural con dispositivos que se usan en el cuerpo (como las gafas inteligentes que mencionaron los usuarios) o asistentes para el hogar.

- Presión competitiva: Esto desafía directamente los modelos de negocio de OpenAI y Google, lo que podría obligarlos a cambiar sus precios u ofrecer versiones más accesibles de sus propios modelos avanzados. El comentario del usuario que dice que esto es "verdadero OpenAI" muestra que hay personas que quieren herramientas poderosas y de código abierto.

- Crear un ecosistema: Para Alibaba, esto podría ser una jugada para crear un grupo de desarrolladores alrededor de sus modelos Qwen, impulsando un uso más amplio y posiblemente aumentando el uso de su plataforma en la nube donde también se aloja el modelo.

En resumen: Un paso importante, pero el camino continúa

Qwen2.5-Omni es sin duda un avance importante en la IA multimodal, especialmente por su integración fluida de diferentes tipos de información y la salida de texto y voz en tiempo real dentro de una nueva arquitectura. Liberar el código fuente del modelo de 7B es una jugada importante que podría tener un gran impacto en el mundo de la IA, dando poder a desarrolladores y empresas de todo el mundo.

Sin embargo, las primeras pruebas muestran algo importante: tener sentidos avanzados no significa automáticamente que se razone bien o que sea fácil de usar. Los errores de lógica y los problemas con los recursos muestran que todavía hay obstáculos por superar.

Para las empresas y los inversores, Qwen2.5-Omni representa una oportunidad y un punto de observación. La oportunidad es usar esta herramienta poderosa y accesible para la innovación. El punto de observación es ver cómo mejora el modelo, cómo la comunidad soluciona sus problemas y cómo los competidores responden a este desafío de código abierto. Alibaba ha jugado una buena carta; estamos esperando los próximos movimientos en el juego de la IA.

Recursos:

- Demo: https://huggingface.co/spaces/Qwen/Qwen2.5-Omni-7B-Demo

- Experiencia de chat de Qwen: https://chat.qwen.ai/

- GitHub: https://github.com/QwenLM/Qwen2.5-Omni

- Modelo Hugging Face: https://huggingface.co/Qwen/Qwen2.5-Omni-7B

- Informe técnico: https://github.com/QwenLM/Qwen2.5-Omni/blob/main/assets/Qwen2.5_Omni.pdf

- Publicación de blog: https://qwenlm.github.io/blog/qwen2.5-omni/