¿Por qué SlowFast-LLaVA-1.5 Podría Ser el Avance Definitivo para la Comprensión de Vídeos Largos—Sin Sobrecarga de Cálculo?

¿El Verdadero Cuello de Botella en el Procesamiento de Vídeo con IA? Tokens, No Solo Cálculo

El contenido de vídeo largo está creciendo de forma exponencial. Desde grabaciones de vigilancia hasta clases educativas, la necesidad de extraer información valiosa de vídeos de varios minutos—o incluso varias horas—nunca ha sido tan grande. Pero para la IA, entender el contexto temporal a largo plazo en vídeo no es solo cuestión de añadir más fotogramas o ajustar un modelo más grande.

¿El verdadero desafío? La eficiencia de los tokens.

La mayoría de los Modelos de Lenguaje Grande de Vídeo (Video LLMs) existentes tienen dificultades para escalar. Procesan grandes cantidades de datos, pero consumen mucho cálculo y memoria, lo que los hace poco prácticos para dispositivos móviles, periféricos o incluso muchas implementaciones empresariales.

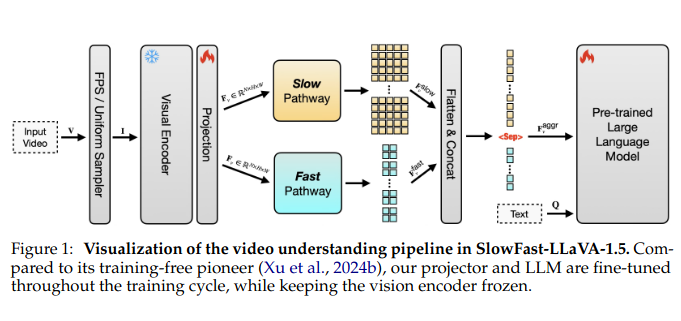

Ahí es donde entra en escena SlowFast-LLaVA-1.5. Desarrollado como una solución reproducible y eficiente en el uso de tokens para la comprensión de vídeos largos, combina un novedoso enfoque de procesamiento de doble flujo con una canalización de entrenamiento ajustada—ofreciendo un rendimiento de última generación incluso con modelos más pequeños (tan bajos como 1.000 millones de parámetros).

Para las empresas que apuestan por la IA escalable, y para los inversores que buscan soluciones de IA implementables en el "edge" (periféricas), este modelo representa un cambio técnico y estratégico significativo.

La Arquitectura de Dos Flujos Que Cambió el Juego

En el corazón de SlowFast-LLaVA-1.5 hay un ingenioso giro arquitectónico tomado prestado y adaptado de trabajos anteriores en reconocimiento de vídeo: un mecanismo SlowFast (LentoRápido). Así es como funciona:

- El flujo lento procesa menos fotogramas a mayor resolución, capturando ricos detalles espaciales de fotogramas clave seleccionados.

- El flujo rápido gestiona muchos más fotogramas pero con menos detalle, centrándose en el movimiento y el flujo temporal.

Al combinar estas vías y agregar sus salidas, el modelo captura tanto lo que está sucediendo en cada fotograma como cómo evolucionan las escenas a lo largo del tiempo—sin ahogarse en tokens.

Este es un cambio con respecto a los transformadores de vídeo monolíticos que luchan por equilibrar la precisión espacial y el alcance temporal. ¿El resultado? SlowFast-LLaVA-1.5 procesa casi el doble de fotogramas utilizando solo el 65% de los tokens en comparación con otros modelos líderes.

Entrenamiento Más Ligero, Adopción Más Amplia

Entrenar modelos de vídeo grandes es notoriamente complicado—a menudo involucrando conjuntos de datos propietarios, canalizaciones de varias etapas y ajuste intensivo en recursos. Los autores de SlowFast-LLaVA-1.5 tomaron una ruta más pragmática:

- Etapa I – Ajuste Fino Solo con Imágenes: El modelo se entrena primero con conjuntos de datos de imágenes disponibles públicamente para establecer una base visual y un razonamiento general.

- Etapa II – Entrenamiento Conjunto de Vídeo e Imagen: Luego se expone a un conjunto seleccionado de datos de vídeo e imagen, lo que permite al modelo aprender tanto la dinámica espacial como la temporal.

Los conjuntos de datos son de código abierto y el enfoque es reproducible—dos atributos que a menudo faltan en las recientes versiones de LLM. Este énfasis en la accesibilidad no es solo académico; reduce la barrera de entrada para empresas más pequeñas o startups que buscan integrar IA de vídeo avanzada.

Puntos de Referencia Que Respaldan la Afirmación

Las métricas de rendimiento se probaron en múltiples puntos de referencia de alto perfil, incluyendo:

- LongVideoBench: 62.5% con el modelo de 7B

- MLVU (Multimodal Long Video Understanding): 71.5% con el mismo modelo

Notablemente, incluso los modelos de 1B y 3B de parámetros ofrecieron resultados competitivos, lo que demuestra que el tamaño no siempre es el factor diferenciador. Ese es un rasgo particularmente atractivo para las empresas que exploran la implementación móvil o basada en el "edge" (periférica).

Además, gracias a su estrategia de entrenamiento conjunto, el modelo no sacrificó las capacidades de razonamiento de imágenes. Compite a la par con los modelos de lenguaje de imágenes dedicados—una clara victoria para el procesamiento multimodal unificado.

Eficiencia Sin Compromiso

En números brutos, las ganancias de eficiencia son claras:

- Procesa hasta 2× el número de fotogramas

- Utiliza ~35% menos tokens que los modelos comparables

- Reduce significativamente los costes de cálculo manteniendo o superando los niveles de rendimiento

Este equilibrio de precisión y eficiencia desbloquea una gama más amplia de casos de uso—desde cámaras inteligentes y sistemas de monitorización IoT hasta asistentes de vídeo integrados en aplicaciones o herramientas de minería de conocimiento empresarial.

Para los inversores, eso significa un mayor retorno de la inversión y menores barreras para la producción.

Valor Estratégico en Todos los Sectores

Integración de IA Empresarial: Con su tamaño compacto y su arquitectura eficiente, SlowFast-LLaVA-1.5 se puede implementar en entornos donde el ancho de banda, el cálculo y la latencia son limitaciones críticas—piense en la vigilancia in situ, el análisis del comportamiento del cliente en el sector minorista o los diagnósticos de maquinaria en el campo.

Plataformas de Medios y Streaming: La creación automatizada de resúmenes, la indexación de búsqueda y la moderación de contenido para medios de larga duración se vuelven factibles a un costo menor.

Tecnología de Asistencia y Accesibilidad: La interpretación en tiempo real de vídeo para usuarios con discapacidad visual se vuelve más viable cuando el procesamiento no requiere una infraestructura a escala de la nube.

Seguridad y Defensa: Los drones y los sistemas de vigilancia en el dispositivo se benefician enormemente de modelos más pequeños que pueden analizar transmisiones en vivo sin tener que subir gigabytes de vídeo.

Limitaciones y Oportunidades Abiertas

Los autores reconocen dos limitaciones clave:

- Limitaciones del Muestreo de Fotogramas: Si bien el muestreo de fotogramas se basa en FPS para la mayoría de los casos de uso, el modelo se establece de forma predeterminada en el muestreo uniforme cuando la longitud del vídeo excede un umbral de fotogramas establecido—lo que podría perder momentos críticos en contenido ultra largo.

- Codificador de Visión Congelado: Para preservar la eficiencia, el codificador de visión permanece congelado durante el entrenamiento. Si bien es eficaz, el ajuste fino de este módulo puede desbloquear un mayor rendimiento, aunque a un mayor costo de cálculo.

Estas limitaciones apuntan hacia los próximos pasos lógicos para futuras versiones: técnicas de muestreo adaptativo, ajuste selectivo del módulo de visión e integración de arquitecturas de memoria eficiente.

Por Qué Esto Importa a la Industria

El paradigma de visión a lenguaje está evolucionando rápidamente. Hasta ahora, la mayoría de los avances en la IA de vídeo se han apoyado en la fuerza bruta—modelos más grandes, conjuntos de datos más grandes, más tokens.

SlowFast-LLaVA-1.5 ofrece un enfoque estratégicamente más ajustado. No es solo un nuevo modelo—es un modelo para cómo la IA eficiente puede escalar la comprensión de vídeo en todas las industrias sin sobrecargar la infraestructura.

Demuestra que la eficiencia de los tokens puede ser tan poderosa como la escala de parámetros—un mensaje que tanto la comunidad de investigación como el ecosistema comercial deben tomar en serio.

Conclusión Final para Inversores y Constructores

Si su hoja de ruta incluye el procesamiento inteligente de vídeo—ya sea para tecnología de consumo, aplicaciones industriales o análisis en tiempo real—SlowFast-LLaVA-1.5 es una señal de que la IA de alto rendimiento no tiene por qué significar IA de alto costo.

Para el capital de riesgo, esto abre la puerta a apoyar a las startups que antes carecían de los recursos para entrenar o ejecutar modelos de vídeo masivos. Para los constructores empresariales, es una oportunidad de implementar IA de vídeo competitiva sin reconstruir toda su pila de infraestructura.